WordPress에 대한 효과적인 스파이더 블록

거미가 아니었다면 웹 콘텐츠를 찾기 위해 Google을 검색 할 수 없습니다. 거미는 웹을 샅샅이 뒤지고 찾은 모든 것을 색인하는 로봇으로, WordPress에서 기사를 검색 할 때 기사가있는 곳을 알 수 있고 사용자에게 안내 할 수 있습니다. 그러나 거미 색인 WordPress를 허용 할 필요는 없으며 평판 좋은 회사의 거미를 차단하는 WordPress의 효과적인 거미 블록을 만드는 쉬운 방법이 있습니다. 더욱 효과적인 스파이더 블록에는 지시 사항을 무시하고 스파이더를 사용하지 않도록 지정한 웹 콘텐츠의 색인을 생성하는 나쁜 스파이더를 식별하고 차단하는 설정 및 프로세스가 포함됩니다.

Robots.txt

스파이더가 귀하의 WordPress 사이트를 방문하면 가장 먼저해야 할 일은 "robots.txt"파일을 읽는 것입니다. 이 파일에는 모든 스파이더 또는 개별적으로 명명 된 스파이더가 색인을 생성 할 수 있거나 만들 수없는 파일 및 디렉토리를 지정하는 규칙이 들어 있습니다. 스파이더는 파일에 고유 한 "사용자 에이전트"코드 또는 "모든 스파이더"를 나타내는 와일드 카드를 찾습니다. 그런 다음 허용되거나 허용되지 않는 파일 및 디렉토리 목록을 읽습니다. 그런 다음 인덱싱이 허용 된 사이트 부분 만 인덱싱을 시작합니다.

블로킹 거미

WordPress의 루트 디렉토리에 "robots.txt"파일을 만들고 사이트 루트 디렉토리의 색인 생성을 허용하지 않는 규칙을 지정하면 WordPress에 대한 효과적인 스파이더 블록을 만들 수 있습니다. 이렇게하면 루트의 모든 하위 디렉토리에 대한 색인 생성이 자동으로 허용되지 않습니다. 파일에서이 규칙이 모든 스파이더 사용자 에이전트 코드에 적용되도록 지정해야합니다. 사이트를 방문하는 모든 거미는 파일을 읽고 사이트의 어떤 부분에도 색인을 생성하지 않고 나가야합니다. 예를 들어, "robots.txt"파일은 다음과 같아야합니다.

사용자 에이전트 : * 금지 : /

좋고 나쁜 거미

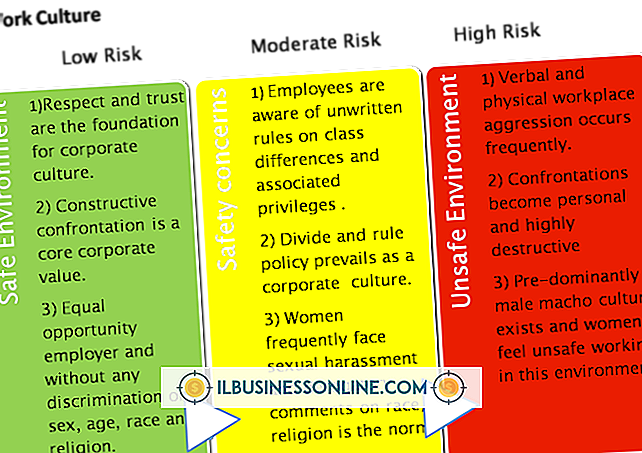

좋은 거미가 있고 나쁜 거미가 있습니다. 좋은 거미는 Google, Yahoo 또는 Microsoft와 같은 평판이 좋은 회사에서 왔으며 "robots.txt"파일의 규칙을 준수합니다. 나쁜 스파이더는 개인적으로 또는 "robots.txt"파일을 의도적으로 무시하고 사용자가 허용하거나 허용하지 않는 내용에 관계없이 사이트의 전체 내용을 색인화하는 회사의 스파이더입니다. 이 로봇은 전자 메일 주소, 스팸 발송자에게 판매 또는 사용자에 관한 개인 정보, 다른 회사에 판매하기와 같은 특정 정보를 검색하는 경우가 있습니다. 스파이더는 사이트 전체를 샅샅이 뒤져서 제대로 숨기거나 보호하지 않은 정보 나 콘텐츠를 찾습니다. 다른 웹 마스터는 불량 스파이더를 다루는 다른 방법을 가지고 있습니다. 일부는 단순히 자신이 누구인지 식별하고 사이트의 콘텐츠를 인덱싱하지 못하게하려고 시도합니다. 다른 사람들은 스파이더의 데이터베이스를 가짜 정보로 중독 시키거나 스파이더를 끝내는 루프로 속여서 종료하거나 중단하도록함으로써 피해를 입 힙니다.

꿀단지

허니팟 또는 타피트는 악성 거미를 식별하여 차단할 수있는 웹 마스터가 사용하는 기술입니다. 전자 메일 주소와 같은 가짜 컨텐트가 포함 된 디렉토리를 추가하고 특히 "robots.txt"파일에서 해당 디렉토리를 허용하지 않으면 허니팟을 만들 수 있습니다. 서버 로그는 디렉토리에 액세스 한 스파이더를 알려주고 사용자 에이전트 문자열과 IP 주소를 기록 할 수 있습니다. 이 정보를 사용하여 WordPress "htaccess"파일에 이러한 불량 스파이더에 대한 액세스를 거부하는 규칙을 만들 수 있습니다. 허니팟은 새로운 악성 로봇이 사이트에 액세스하지 못하도록 정기적으로 점검해야합니다.