Robots.Txt를 사용하여 하위 도메인을 차단하는 방법

웹 사이트는 소규모 비즈니스를 홍보하고 제품 및 고유 한 자격을 홍보하는 좋은 방법입니다. 대규모 웹 사이트를 관리하는 경우 몇 개의 하위 도메인을 사용하고 각 하위 도메인은 웹 호스트에 자체 폴더를 가지고 있습니다. 검색 엔진 크롤러가 특정 하위 도메인을 구문 분석하고 색인을 생성하지 않게하려면 robots.txt 파일을 사용하여 차단할 수 있습니다.

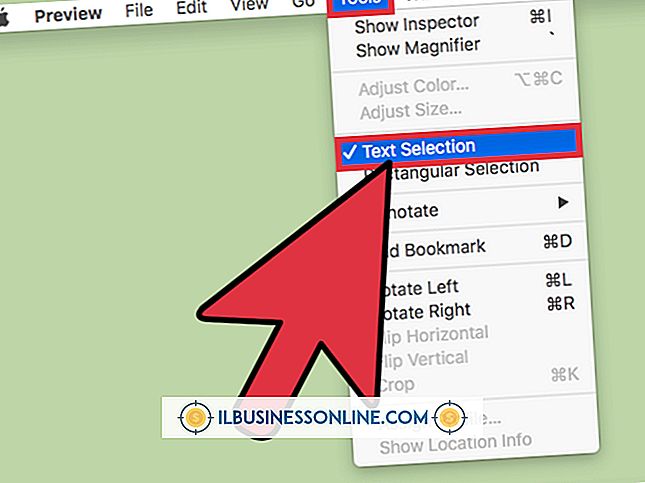

1.

화면의 왼쪽 하단에있는 시작 단추를 클릭하십시오.

2.

시작 메뉴의 아래쪽에있는 검색 상자에 "메모장"을 입력하십시오.

삼.

메모장을 시작하려면 시작 메뉴 상단의 프로그램 섹션에서 "메모장"을 클릭하십시오. 메모장에 새 문서가 자동으로 만들어집니다.

4.

이 두 줄을 메모장 문서에 삽입하여 모든 로봇이 하위 도메인을 구문 분석하지 못하도록 차단합니다.

사용자 에이전트 : * 금지 : /

5.

"다른 이름으로 저장"창을 열려면 "Ctrl-S"를 누르십시오.

6.

"파일 이름"상자에 "robots.txt"를 입력하고 파일을 저장할 폴더를 선택한 다음 "저장"을 클릭하여 저장하십시오.

7.

검색 엔진 크롤러로부터 보호하려는 각 도메인의 루트 디렉토리에 저장 한 robots.txt 파일을 업로드하십시오. 루트 디렉토리는 최상위 디렉토리입니다.

팁

- FTP 클라이언트 소프트웨어 또는 호스트의 웹 파일 관리자를 사용하여 파일을 업로드 할 수 있습니다.

인기 게시물

중소기업은 생산 수준을 조정하기 위해 재고를 알아야합니다. 익숙한 가장 중요한 재고 목록 중 하나는 완성품 인벤토리입니다. 이는 판매 가능한 상품의 양을 나타냅니다. 다음 해로 시작할 인벤토리의 양을 알 수 있도록 해당 연도의 종료 된 완제품 재고를 계산하십시오. 1. 현재 연도의 시작 재고로 사용할 전년도 완성품의 결산액을 소지합니다. 예를 들어, 2010 년의 종료 된 완제품 재고가 10, 000 달러라면 2011 년의 완제품 재고가됩니다. 2. 생산에 사용 된 직접 재료의 비용, 생산에 사용 된 직접 노동 비용, 공정중인 재화의 비용을 합산 한 다음 공정중인 결말을 뺍니다. 이렇게하면 해당 연도에 제조 된 총 비용을 얻을 수 있습니

자세한 내용을

Microsoft Word는 기존 문서 또는 양식에 입력하는 것을 포함하여 화면의 문서와 상호 작용할 수있는 다양한 방법을 제공합니다. 하루 동안 주문을 승인하기 위해 라인에 이니셜을 입력하고 전자 서신에서 디지털 서명을 스크 롤하고 주문 양식을 기입하고 문서의 날짜를 포함시켜야합니다. 위의 모든 라인은 이미 제자리에 있습니다. 문서에. Word 문서에 추가하면 페이지 흐름을 방해 할 수 있지만 나머지 내용은 그대로 유지하면서 위의 줄을 작성하는 빠른 해결 방법이 있습니다. 1. Word 문서를 열고 줄이있는 구역으로 스크롤하십시오. 선이 작 으면 선이 크고 화면에서보기 쉽도록 확대 / 축소 도구를 사용하여 확대 할 수 있습니다. 2. 삽입 탭을 클릭 한 다음 &qu

자세한 내용을

대부분의 사람들은 MP3 플레이어를 사용하여 컴퓨터에서 다운로드 한 음악을 듣습니다. 그러나 사업을 운영하는 경우 GPX MP3 플레이어의 음악뿐만 아니라 다양한 음악을들을 수 있습니다. 예를 들어, 오디오 강좌를들을 수 있습니다. 포드 캐스트 및 기타 녹음. MP3 플레이어는 효과적인 학습 도구가 될 수 있습니다. 이 파일을 플레이어에 추가하는 것은 어렵지 않습니다. 1. 기기 상단의 "재생 / 일시 정지"버튼을 눌러 MP3 플레이어를 켭니다. 2. 제공된 USB 케이블을 사용하여 MP3 플레이어를 컴퓨터에 연결하십시오

자세한 내용을

직원 성과 평가 도구가 있으므로 직원의 진도를 추적 할 수 있습니다. 추적 진행이 모든 직무 기술에 필수적인 것은 아니지만 직원의 실적이 좋고 취약한 곳이 어디인지를 이해하는 것이 회사 성장과 장기간의 직원 만족에 절대적으로 필요하다는 것을 알 수 있습니다. 다양한 유형의 성과 평가를 통해 직원 성공의 여러 측면을 파악할 수 있습니다. 표준 평가 척도 평가 척도는 특정 행동, 목표 및 특성을 취하고이를 척도로 평가합니다. 모든 직원 또는 팀원은 개인뿐 아니라 핵심 팀 선수에 대한 통찰력을 부여하는 동일한 기준으로 점수가 매겨집니다. 등급 척도는 일반적으로 수치를 기반으로합니다 (예 : 1 ~ 5의 척도를 사용하여 5가 최상의

자세한 내용을

조직은 장기간 직위를 보유한 직원을 정기적으로 재 분류 할 수 있습니다. 직원을 재 분류하는 데 사용되는 방법은 많은 요인에 따라 달라집니다. 사설 및 정부 기관 모두 일반적으로 직원의 업무 성과를 재평가하기위한 시스템을 갖추고 있습니다. 직원의 직무 및 책임이 변경되면 조직은 직원의 재 분류 여부를 평가할 수 있습니다. 재 분류 재 분류 (Reclassification)는 조직이 직원의 경력 개발을 위해 다음 단계로 자연스럽게 진보 할 수있는 한 가지 방법입니다. 조직은 직원이 복잡성, 책임, 의사 결정 권한 또는 필요한 지식의 변경을 수행하는 직무의 범위를 결정할 때 직원을

자세한 내용을